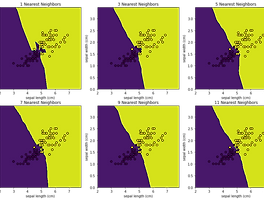

CH06_02. KNN 실습 (Python)

1 Iris 데이터와 KN import pandas as pd import numpy as np import matplotlib.pyplot as plt np.random.seed(2022) 1.1 1. Data 1.1.1 1.1 Data Load from sklearn.datasets import load_iris iris = load_iris() data = iris.data target = iris.target target >>> array([0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0..

CH06_02. KNN 실습 (Python)

1 Iris 데이터와 KN import pandas as pd import numpy as np import matplotlib.pyplot as plt np.random.seed(2022) 1.1 1. Data 1.1.1 1.1 Data Load from sklearn.datasets import load_iris iris = load_iris() data = iris.data target = iris.target target >>> array([0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0..